知乎网友热议最差论文,战火烧到Reddit论坛

今年CVPR共有1200多篇论文被接收,官方评出了最佳论文,民间则评出了最差论文。

2019年CVPR有哪些糟糕的论文?

这个问题不仅在知乎上火了,甚至被出口到了国外论坛ML板块。

顶会也有水论文?答案是Yes。不仅有水的,甚至有水得很夸张的。

号称进步巨大,实则不work;被NIPS、AAAI和ICLR一直拒的论文中了Oral;化身剪刀手拼接已发表过的文章……这也就不说什么了,但抄袭已发表论文的Idea,做低baseline这也过分了吧?

而这个问题也引发了对学术圈学术氛围的质疑,“打招呼”让双盲同行评审成了空谈?追求短期反馈疯狂水论文成常态?

水论文这件事,实在引人深思。

最差论文提名

最差论文没有统一的标准,自然也就很难达成一致,知乎网友分别从6个不同角度提出了质疑。

下面开始知乎网友自发组织的worst paper“颁奖典礼”。

质疑1:号称进步巨大,效果平平无奇。

首先是位置最高的回答,答案提供者是一名来自图森的感知算法工程师王峰。

他自己也在这个领域研究类似的问题,也做出了一些小修小补,但觉得意义不大,所以就没发论文。

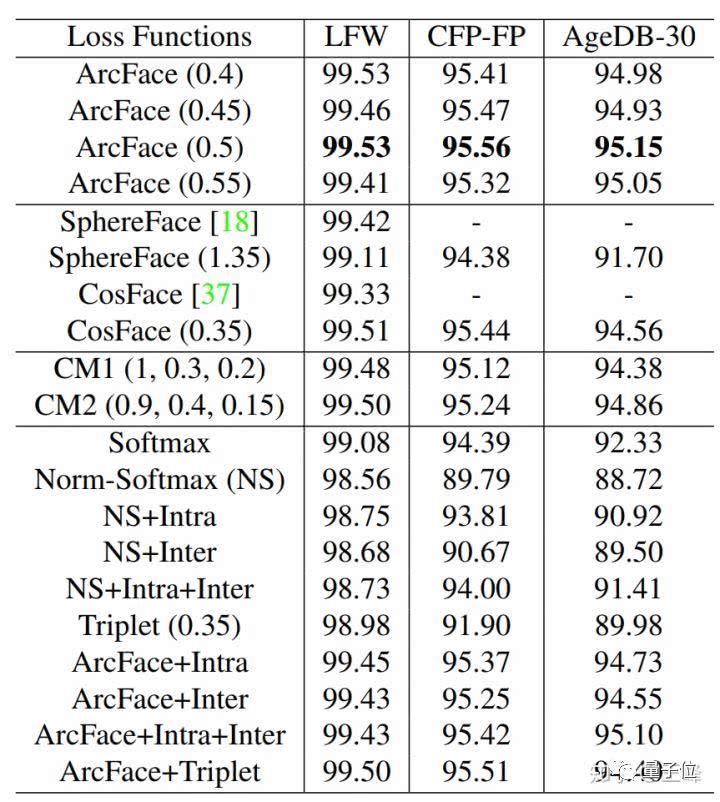

但是有人把结果发到了CVPR上,而且这篇研究人脸识别的论文还号称进步巨大,但实际效果如何呢?请数据说话:

提升效果并不明显。“真的、真的不work!”

但是王峰还是给了一些正面评价:

不过还是要表扬一下第二篇论文,里面还提出了一个Noise Resistance Softmax loss,这个损失的形式很复杂,但思想值得一看,应该能改进出一个更简单的形式。

原回答链接:

http://www.zhihu.com/question/327139341/answer/712075929

质疑2:和前年论文高度相似,审稿人怎么了?

直接把别人的成果算成是自己的,连摘要都高度相似。

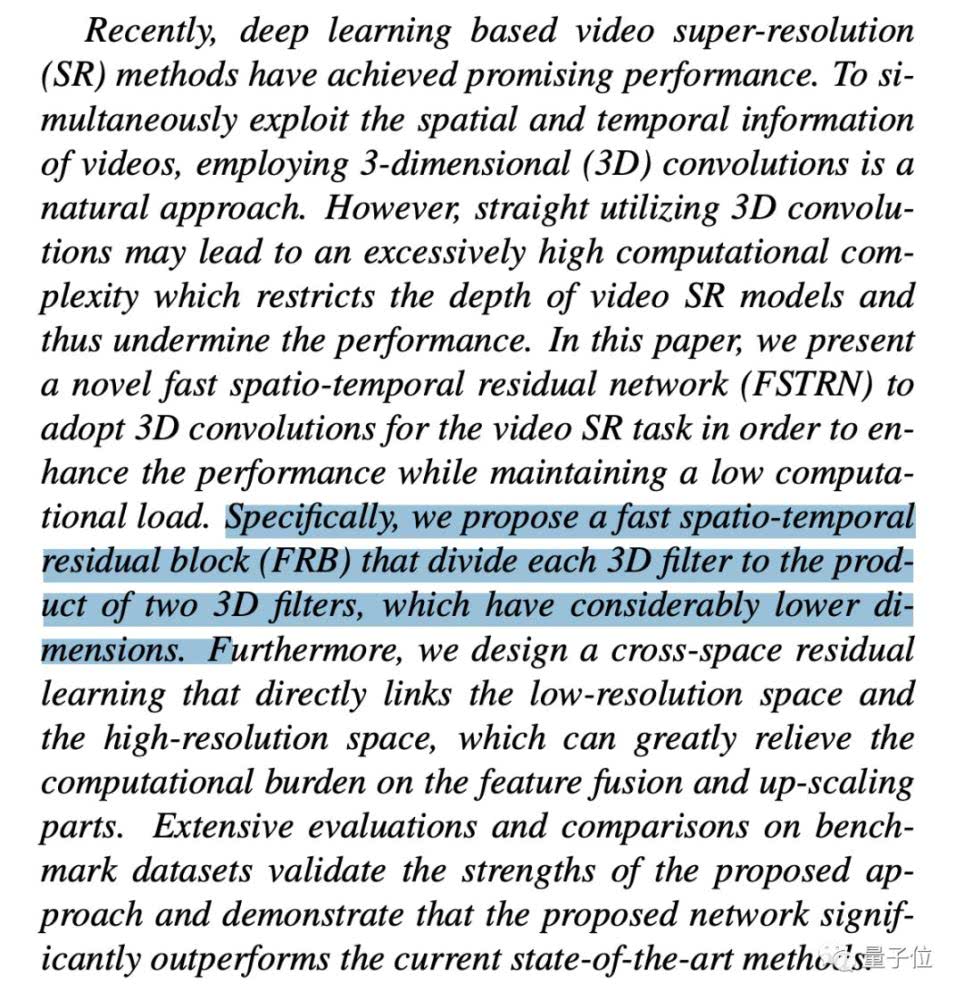

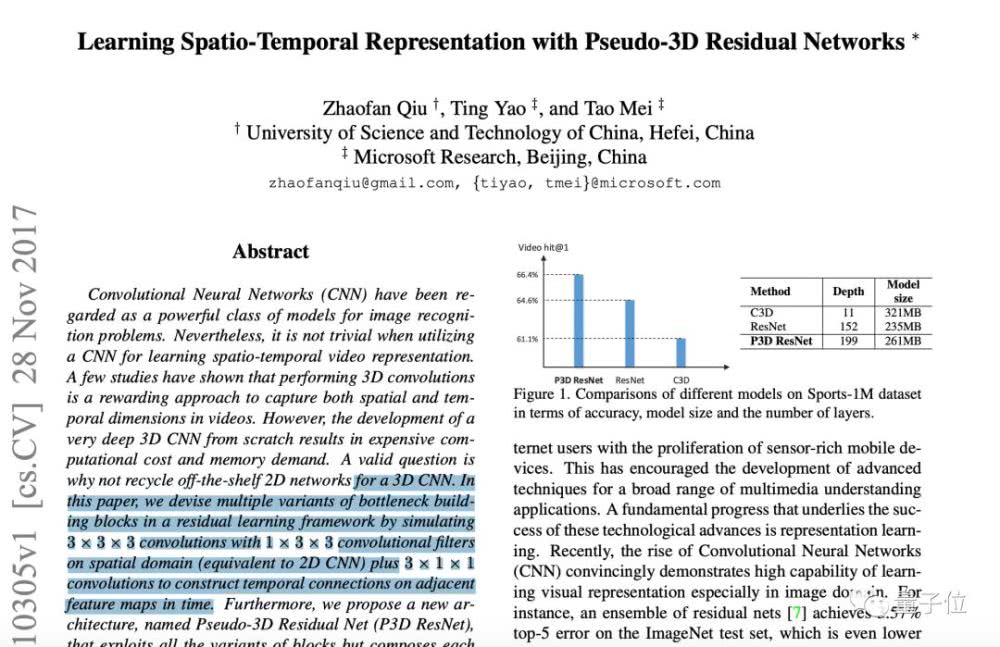

这是CVPR 2019文章的摘要:

这是ICCV 2017文章的摘要:

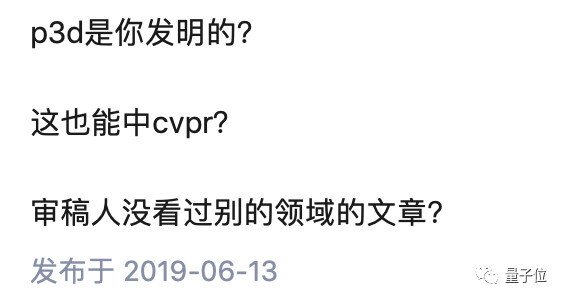

匿名网友向作者提出疑问三连:

虽然这篇文章是不点名批评,但是稍微搜索一下还是能知道作者是谁的,算是给别人留了点面子。

质疑3:超不过对手,那就拉低对手。

自己论文效果不好怎么办,调低baseline啊!

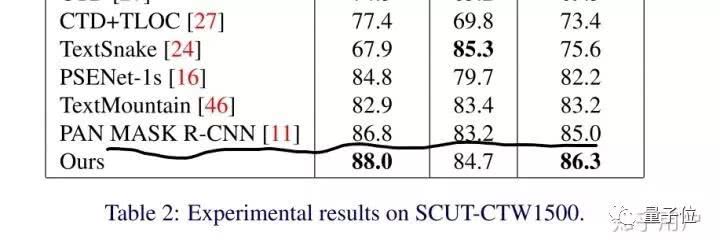

比如这篇文章里Mask R-CNN的baseline分数只有不到70分,而另一篇文章在同样的两个数据集上做出的baseline分数超过了80分。

等于作者将baseline整整做低了十几分,终于让自己的结果“超越”了Mask R-CNN。

答案提供者也忍不住吐槽:

现在发文章不容易啊,不仅自己的实验结果需要造假,还要把那么经典的方法踩一踩,敢问作者你的良心不会痛吗??

质疑4:被其他顶会一直拒的论文中了Oral?

有知乎网友表示,会议培养新人也没什么,但被NIPS,AAAI,ICLR这些顶会一直拒的论文一下中了CVPR Oral也太玄学了吧?这也太浪费读者时间了。

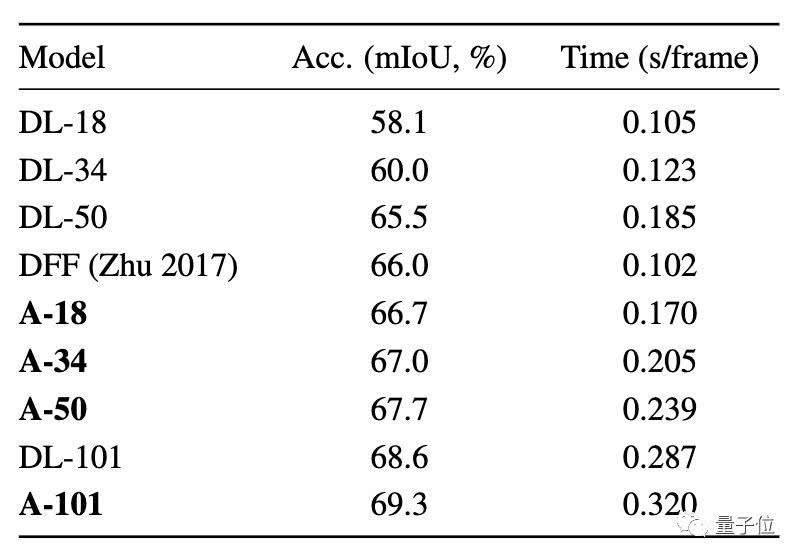

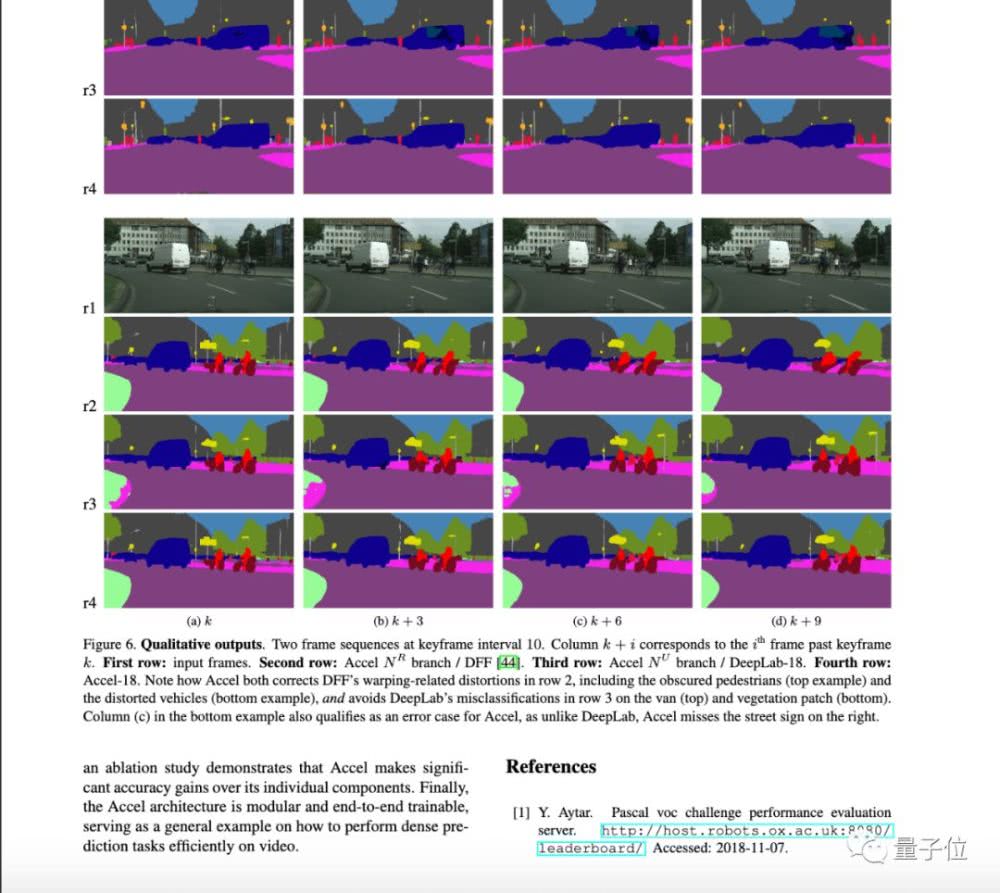

这位网友举了伯克利的这篇《Accel: A Corrective Fusion Network for Efficient Semantic Segmentation on Video》为例子。这是一篇有关语义分割的论文,但作者显然是该领域的新手小白。

看这个baseline,未免有点低吧?

再看文章的第八页,结合文章的内容,不禁让人怀疑这是在填位置……

方法本身也没有什么创新性,中个Workshop也就算了,作为一篇Oral实在令人很失望……

还有网友补充,这篇论文的某个strong accept的意见里weakness部分只写了一个句号……emmm……审稿人真的有在好好看文章吗?

质疑5:发过的论文拼一拼,就又能中顶会啦?

听说拼一拼别人的好音乐,就能成为火遍全网的“原创音乐人”。那么在学术界,剪刀手也一样有春天?

知乎网友很气愤:拼凑的论文比灌水更恶劣,水论文还能提供一点新知识呢。

被指控的论文是这一篇:《Self-Supervised Representation Learning by Rotation Feature Decoupling》。

版权保护: 本文由 沃派博客-沃派网 编辑,转载请保留链接: http://www.bdice.cn/html/68523.html